在中文搜索与文本处理领域,IK分词器凭借其精准的语义切分能力,已成为Elasticsearch生态中不可或缺的插件。它不仅解决了中文分词的技术难题,还通过灵活配置与高效性能,为开发者提供了从基础分词到智能扩展的全套解决方案。以下将从核心特点、安装部署、安全实践及生态展望四个维度,全面解析IK分词器的应用价值。

一、核心特点:精准与灵活的双重优势

IK分词器的核心优势体现在多粒度分词模式与动态扩展能力上:

1. 智能分词模式

ik_smart(最粗粒度):适用于快速索引与初步语义分析,如将“中华人民共和国国歌”切分为“中华人民共和国”和“国歌”。

ik_max_word(最细粒度):用于深度文本挖掘,例如将同一短语拆解为“中华人民”“华人”“人民共和国”等组合,覆盖所有可能的语义单元。

2. 动态词库扩展

支持本地词典(如`custom.dic`)与远程词库(通过HTTP接口),可实时更新行业术语或网络新词(如“奥力给”“传智播客”)。

提供停用词过滤功能,可屏蔽无意义的虚词(如“的”“了”),提升搜索效率。

这一设计使得IK分词器既能满足通用场景,也能适应金融、医疗等专业领域的定制化需求。

二、安装部署:三步完成高效配置

步骤1:下载与版本匹配

官方渠道:从GitHub仓库[medcl/elasticsearch-analysis-ik]下载与Elasticsearch版本严格对应的ZIP包(如ES 7.17.21需选择`v7.17.21`版本)。

避坑提示:早期版本存在打包后版本号不一致的问题(如7.6.2编译后降级为7.4.0),务必核对`pom.xml`文件。

步骤2:插件安装

标准环境:将ZIP包解压至Elasticsearch的`plugins/analysis-ik`目录,重启服务即可生效。

Docker部署:通过数据卷挂载(如`es-plugins`)将IK插件导入容器,执行`docker restart es`重启实例。

步骤3:功能验证

发送测试请求至`

json

POST /_analyze

text": "慕课网是程序员的学习平台",

analyzer": "ik_max_word

若返回结果包含“慕课网”“程序员”等完整词汇,说明安装成功。

三、安全实践:保障分词的可靠性与隐私性

1. 词库更新机制

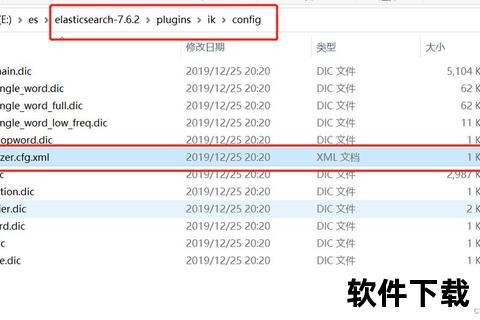

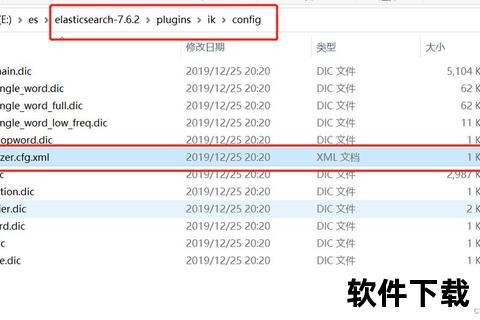

本地化配置:优先通过`IKAnalyzer.cfg.xml`加载本地词典(如`ext.dic`),避免因网络延迟或中断导致服务异常。

远程热更新:若需动态加载词库,确保HTTP服务启用HTTPS并设置鉴权,防止敏感词库泄露。

2. 权限控制

限制Elasticsearch节点的外网访问权限,仅开放必要端口(如9200、9300),减少攻击面。

定期审计`ext_dict`与`remote_ext_dict`配置,避免恶意词库注入。

四、用户评价与未来展望

用户反馈

正面评价:开发者普遍认可其分词准确性与易用性,尤其是自定义词库功能显著提升了垂直领域的搜索体验。

改进建议:部分用户指出官方文档的示例较少,且远程词库的热更新响应时间(默认1分钟)需进一步优化。

技术趋势

多语言支持:新版本逐步增强对混合文本(中英日韩)的分词能力,适应全球化业务场景。

AI集成:结合机器学习模型自动识别新词与歧义短语,减少人工维护成本。

五、为中文搜索注入智能基因

IK分词器以其开箱即用的便捷性、灵活扩展的兼容性,成为Elasticsearch中文生态的基石。无论是初创企业的轻量级应用,还是大型平台的高并发场景,均可通过合理配置发挥其最大效能。未来,随着自然语言处理技术的深化,IK分词器有望在语义理解与实时分析领域实现更大突破,持续推动搜索技术的智能化演进。

(本文内容基于公开资料与社区实践,具体功能以官方文档为准。)

参考来源:

Windows环境下的IK分词器安装与版本兼容性问题

分词模式对比与本地词库配置方法

Docker部署与远程词库热更新实现

安全实践与未来技术发展方向